Contenu

La crise de l’été 1944 et la réorganisation du laboratoire

Plutonium 240 Early experiments on both uranium and plutonium provided welcome results. Uranium emitted neutrons in less than a billionth of a second- just enough time, in the world of nuclear physics, for an efficient explosion. Emilio Segrè later provided an additional cushion with his discovery in December 1943 that, if cosmic rays were eliminated, the subcritical uranium masses would not have to be brought together as quickly as previously thought; nor would the uranium have to be as pure. Muzzle velocity for the scaled down artillery piece could be lower, and the gun could be shorter and lighter. Bacher’s engineering division patiently generated the essential cross-sectional measurements needed to calculate critical and efficient mass. (The cross section is a measurement that indicates the probability of a nuclear reaction taking place). The same group utilized particle accelerators (Van de Graaf) to produce the large numbers of neutrons needed for its cross-sectional experiments. Bacher’s group also compiled data that helped identify tamper materials that would most effectively push neutrons back to the core and enhance the efficiency of the explosion. Despite Los Alamos’s postwar reputation as a mysterious retreat where brilliant scientists performed miracles of nuclear physics, much of the work that led to the atomic bombs was extremely tedious.

Le 5 avril 1944, arrivèrent les premiers échantillons de quelques grammes de plutonium venant du réacteur expérimental X-10 d’Oak Ridge. Emilio Segrè les utilisa pour mesurer plus précisément les sections efficaces du plutonium et affiner l’évaluation de la masse critique de plutonium nécessaire (selon la configuration choisie). À la différence du plutonium synthétisé avec les cyclotrons, le plutonium 239 des réacteurs était contaminé par 0.1% de plutonium 240. C’était prévisible, puisque restant dans le réacteur une fois formé, le plutonium 239 avait le temps d’absorber un neutron de plus et, au lieu de fissionner, de se transformer dans 30% des cas en plutonium 240 d’une durée de vie de 6 500 ans. Les physiciens s’attendaient à ce qu’il soit beaucoup plus spontanément fissile que le 239, par analogie avec l’uranium 238 car tous les deux ont un nombre pair de protons et de neutrons. La mauvaise nouvelle était l’ampleur inattendue, et considérable, de cette fission spontanée.

| Noyau | U 235 | U 238 | Pu 239 | Pu 240 |

|---|---|---|---|---|

| Neutrons/kg/s | 0.01 | 13.6 | 22.0 | 920 000 |

Dans une bombe contenant 50 kg d’uranium 235, le taux de fission spontanée conduisait à un flux de 0.5 neutron par seconde, et le risque de prédétonation pendant la milliseconde de l’assemblage était quasi-nul. Si le processus d’enrichissement ne se révélait pas capable d’isoler de l’uranium 235 pur, le risque de prédétonation augmenterait : avec un enrichissement de 90% seulement, les 10% d’uranium 238 conduiraient à 70 neutrons/s. Mais le risque de prédétonation demeurait faible. Le risque était plus grand dans le cas du plutonium 239, avec ses 22 neutrons/kg/s, d’où la nécessité très tôt reconnue de rapprocher les masses sous-critiques en moins d’une milliseconde, et donc de recourir à un canon plus long.

Mais la contamination en plutonium 240 avec son taux de fission spontanée de près de un million de neutrons/kg/s, changeait la donne : même une très faible contamination de 0.1% de plutonium 240 conduirait à 10 000 neutrons/s pour les quelque 10 kg de plutonium nécessaires. Ces neutrons risquaient d’allumer prématurément la bombe même si le rapprochement des deux masses sous-critiques de plutonium ne durait que 100 µs. Pour corriger cela, il aurait fallu augmenter très fortement la vitesse de rapprochement en utilisant un canon de 20 (calcul ?) mètres de long. La bombe devenait alors beaucoup trop encombrante pour être emportée par un B-29. Ces conclusions furent momentanément gardées secrètes, en attendant plus de statistiques, et Segrè continua ses observations. Il confirma ses premières mesures pour le plutonium du réacteur X-10, et surtout il indiqua qu’il fallait s’attendre à un taux de fissions spontanées très supérieur dans le plutonium des réacteurs de Hanford, qui allait être exposé beaucoup plus longtemps à un haut flux de neutrons, et risquait de contenir 1 à 5% de plutonium 240.

Les réacteurs de Hanford étaient beaucoup trop avancés pour permettre un modification éventuelle de la production de plutonium, à supposer même qu’une idée soit trouvée évitant le problème de la fission spontanée. Il fallait « faire avec » le plutonium tel qu’il arriverait de Hanford. Oppenheimer fit part de ces conclusions le 4 juillet à ses collègues. Le « canon à plutonium » Thin Man fut abandonné le 17 juillet. Le 20 juillet, toute l’organisation de Los Alamos fut refondue et l’effort de développement se reporta sur Little Boy et sur Fat Man.

Mais, en juillet 1944, ces deux projets paraissaient l’un comme l’autre bien loin de pouvoir aboutir :

- il était pratiquement certain qu’une bombe comme Little Boy fonctionnerait du premier coup, mais quelques grammes seulement d’uranium 235 avaient pu être isolés ;

- il était pratiquement certain que les réacteurs de Hanford fourniraient assez de plutonium, mais il n’y avait pas de modèle fiable de bombe pour l’utiliser.

En effet aucune des méthodes d’enrichissement isotopique ne fonctionnait alors correctement à Oak Ridge : les calutrons de Y-12 n’avaient fourni que quelques grammes d’uranium 235, le bâtiment de K-25 était à moitié terminé mais les barrières poreuses n’étaient pas au point, et la décision de construire S-50, l’usine de séparation thermique, dut être prise en catastrophe. Dans les hypothèses les plus optimistes, Oak Ridge fournirait à peine de quoi faire une seule bombe à l’été 1945 (et peut-être une seconde à la fin de l’automne) et l’intérêt militaire d’une bombe unique semblait réduit.

Par ailleurs, les essais d’implosion avaient des résultats désastreux : toutes les tentatives de placer des charges explosives tout autour d’une sphère métallique conduisaient à une déformation inacceptable de cette sphère au lieu de la comprimer en conservant sa forme sphérique. Différentes tentatives d’intercaler des zones neutres entre les explosifs (pour réduire la formation de jets quand les détonations fusionnaient) échouèrent. De ce fait, il semblait impossible d’approcher de la masse critique. Les équipements de diagnostic étaient insuffisants (on utilisa ensuite des caméras ultrarapides à rayons X).

Au cas où Los Alamos ne trouverait pas de solution, Arthur Compton réunit à Chicago les principaux membres du Met Lab pour trouver une issue. Wigner proposa de fissionner le plutonium et d’utiliser les neutrons de la fission pour convertir du thorium 232 en uranium 233, que l’on pourrait extraire chimiquement du thorium. L’uranium 233 est fissile comme l’uranium 235 et le plutonium 239 et il permettrait de réaliser une bombe. L’idée inquiéta Conant qui se demanda si les Allemands ne pouvaient pas avoir eu la même et s’être déjà lancés dans une bombe à l’uranium 233. Seaborg indiqua que l’uranium 233 risquait toutefois d’être contaminé en uranium 232, sans doute aussi spontanément fissile mais surtout radioactif alpha (imposant donc de se débarrasser de toute impureté capable de générer des neutrons par bombardement alpha). Le convertisseur proposé par Wigner ne fut pas nécessaire, mais il eut une grande influence car c’était le premier projet détaillé de réacteur modéré et refroidi par eau légère. La « voie du thorium » est toujours d’actualité, en particulier en Inde qui possède de grandes réserves de thorium.

Crise

Au cours de l’été 1944, l’avenir du programme Manhattan parut donc très compromis : non seulement les deux méthodes envisagées pour réaliser une bombe se heurtaient chacune à des difficultés immenses, mais en plus sa nécessité militaire semblait s’estomper :

- des indications convergentes montrait que le programme nucléaire allemand était très en retard sur le programme américain et ne conduirait pas à une bombe avant la fin de la guerre en Europe. Dès janvier 1944, les services d’espionnage britanniques s’étaient convaincus que le programme allemand avait très peu avancé, mais les services américains n’étaient pas convaincus et ils mirent sur pied les missions Alsos, d’abord en Italie, puis en France et enfin en Allemagne. Le 10 juin, Bush reçut des indications qu’il y avait peu de risques de bombe allemande. Cela fut confirmé lorsque Pasch et Goudsmit rencontrèrent Joliot à Paris fin août, et définitivement assuré en arrivant à Strasbourg fin novembre. Weizsäcker en était parti, mais les documents laissés montraient la stagnation des recherches allemandes depuis 1942 : la possibilité même d’une réaction en chaîne n’était pas établie ! Les États-Unis n’imaginèrent jamais qu’il y ait pu y avoir un programme japonais ;

- les Américains progressaient rapidement dans le Pacifique (conquête des Mariannes en juillet, débarquement aux Philippines et anéantissement de la Marine Impériale Japonaise à Leyte en octobre, sans compter le très efficace blocus du Japon par la guerre sous-marine);

- les débarquements de Normandie en juin et de Provence en juillet avaient permis aux Alliés de progresser rapidement en France et de se rapprocher de l’Allemagne, tandis que l’Armée Rouge avança profondément de juin à août sur le front de l’Est, lors de l’opération Bagration, et elle se trouvait désormais à 500 km à peine de Berlin.

Mais les dépenses engagées dépassaient très largement alors le milliard de dollars, les physiciens étaient stimulés par ces problèmes et ils avaient envie de les résoudre, les militaires rêvaient d’une arme exceptionnelle, et les politiques envisageaient déjà l’après-guerre comme un équilibre plus ou moins glacial avec l’URSS. Le 7 août 1944, Groves annonça à Stimson qu’une bombe à l’uranium ne serait prête qu’autour du 1° août 1945 (et peut-être une ou deux de plus avant la fin de 1945), et que, si les expériences se déroulaient bien, une bombe au plutonium pourrait aussi être prête en même temps (avec un rythme de livraison plus rapide, une par mois). Il était probable que la guerre serait alors terminée en Europe, ce qui signifiait que les bombes nucléaires seraient destinées au Japon, comme cela avait envisagé par le Military Policy Committee dès mai 1943. Groves déclara par la suite que, dans son esprit, il avait toujours été clair que l’arme nucléaire était avant tout dirigée contre le Japon (plus que contre l’Allemagne, en particulier pour une question de calendrier), mais également contre les Russes. Pour toutes ces raisons, le programme Manhattan ne fut pas ralenti mais au contraire intensifié.

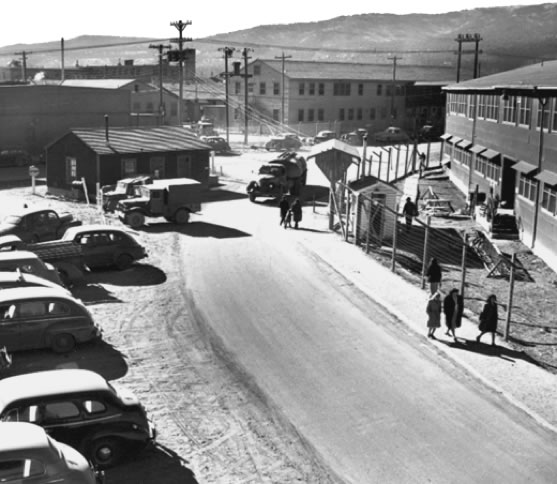

Même les scientifiques les plus hauts placés ne furent pas avertis de l’absence de risque de bombe allemande : Bethe ne le sut qu’en mars 1945, neuf mois après Bush ! Le 20 juillet, la direction de los Alamos décida une réorganisation complète du travail à Los Alamos, en lui donnant pour priorité absolue la mise au point d’un mécanisme d’implosion fiable. En 15 jours, tout fut réorganisé autour de l’implosion et de Fat Man, Little Boy recevant une priorité secondaire puisque la bombe elle-même ne posait pas de problème particulier et que la fourniture d’uranium 235 n’était pas du ressort de Los Alamos. Le personnel à Los Alamos passa d’environ 1 100 en mai à plus de 2 500 un an plus tard ( ?). De fait le programme nucléaire accéléra début 1945 (avec la résolution des problèmes liés à la séparation de l’uranium 235, et la résolution du problème de l’implosion), et plus encore après le 8 mai 1945 : Oppenheimer dit que le rythme ne fut jamais aussi intense à Los Alamos qu’entre mai et août 1945 !

Réorganisation

Oppenheimer était désormais assisté de deux directeurs-adjoints, Fermi et Parsons. La division de théorie restait sous la direction de Hans Bethe et ses 5 groupes passèrent progressivement à 8 :

- T-1 : dynamique de l’implosion (Rudolf Peierls)

- T-2 : théorie de la diffusion (Robert Serber)

- T-3 : efficacité (Victor Weisskopf)

- T-4 : problèmes de diffusion (Richard Feynman)

- T-5 : calculs numériques (Donald Flanders)

- T-6 : calculs numériques sur IBM (Stanley Frankel et Eldred Nelson) en septembre 1944

- T-7 : dommages (Joseph Hirschfelder) en novembre 1944

- T-8 : arme composite (George Placzek) en mai 1945

La division expérimentale de Bacher devint la Research Division, sous la direction désormais de Robert R. Wilson, mais sans grand changement :

- R-1 : cyclotron (sous la responsabilité directe de R.R. Wilson)

- R-2 : générateurs électrostatiques (John H. Willams)

- R-3 : sources D-D (John Manley)

- R-4 : radioactivité (Emilio Segrè)

Une division F (comme Fermi) avait la charge des divers projets sans implication sur l’objectif principal : réaliser une bombe très vite. Sous la direction de Fermi, elle avait 4 groupes :

- F-1 : la « Super » (Teller)

- F-2 : LoPo (Lionel Daniel Percival « Perc » King)

- F-3 : expérimentation pour la « Super » (Egon Bretscher)

- F-4 : études de fission (Herbert Anderson)

La division Ordnance fut éclatée en trois divisions : O (Ordnance, s’occupant de Little Boy) sous l’autorité de Francis Birch (supervisé par Parsons), G (Weapon Physics, mais le G était là pour Gadget, en charge de la conception finale de Fat Man) dirigiée par Bacher et X (eXplosives) dirigée par Kistiakowsky. Chacune avait une dizaine de groupes. La division Chimie-Métallurgie prit aussi plus d’ampleur avec 16 groupes. S’ajoutèrent deux autres divisions, l’une en mars 1945 sous la direction de Bainbridge pour préparer Trinity, l’autre également en mars sous l’autorité directe de Parsons, assisté de Ramsey, pour gérer le projet Alberta.

Conant shipped as many scientists as could be spared from Chicago and Oak Ridge to Los Alamos, hired every civilian machinist he could lay his hands on, and arranged for Army enlisted men to supplement the work force (these GIs were known as SEDS, for Special Engineering Detachment). Hartley Rowe, an experienced industrial engineer, provided help in easing the transition from research to production. Los Alamos also arranged for a rocket research team at the California Institute of Technology to aid in procurement, test fuses, and contribute to component development. These changes kept Los Alamos on track as weapon design reached its final stages.

Masse critique: « chatouiller la queue du dragon »

Calcul théorique : la masse critique dépend de la géométrie (sphère pleine, sphère creuse, cylindre plein, cylindre creux) et de la densité. Pour une sphère pleine homogène, elle varie comme l’inverse du carré de la densité : l’implosion permet d’économiser beaucoup de matière fissile en augmentant fortement la densité, ce que suggèrent en octobre 1943 Teller et von Neumann

Plus précisément M = m3n3/2/(fσ3ρ2) où m est la masse du noyau, n le nombre de diffusions par fission, ρ la densité, σa section efficace de capture et f un fudge factor dépendant de la géométrie

Ces méthodes permettent d’évaluer la masse critique pour une sphère homogène de densité normale à 52 kg pour l’uranium 235 (diamètre 17 cm) et à 10 kg pour le plutonium 239 (diamètre 10 cm). Pour de l’uranium enrichi à 15% d’U235, la masse critique dépasse les 600 kg.

L’effet de géométries plus complexes qu’une sphère homogène est pratiquement impossible à calculer exactement, et très difficile à modéliser. Développement des méthodes de Monte-Carlo par Nicholas Metropolis, Stanislaw Ulam (qui leur a donné ce en raison de l’emploi de tirages aléatoires par la méthode, comme au casino de Monte-Carlo) John von Neumann et Enrico Fermi pour l’étude de la diffusion des neutrons dans un matériau fissile, puis pour la modélisation des ondes de choc. Le premier calculateur IBM arriva en avril 1944.

Ulam joined the Manhattan Project at Los Alamos, working with von Neumann at his invitation. While there, Ulam suggested the Monte Carlo Method for evaluating complicated mathematical integrals that arise in the theory of nuclear chain reactions. This suggestion led to the more systematic development of Monte Carlo by von Neumann, Metropolis and others, which greatly aided in solving many of the complex problems in creating an atomic bomb.

Stanislaw Ulam (1909-1984) né à Lvov, élève de Banach (PhD de maths à Lvov en 1933), fuit la Pologne en 1938 et obtient un poste à l’IAS de Princeton grâce à Neumann.

MONTE-CARLO Physicists at Los Alamos Scientific Laboratory were investigating radiation shielding and the distance that neutrons would likely travel through various materials. Despite having most of the necessary data, such as the average distance a neutron would travel in a substance before it collided with an atomic nucleus or how much energy the neutron was likely to give off following a collision, the problem could not be solved with theoretical calculations. John von Neumann and Stanislaw Ulam suggested that the problem be solved by modeling the experiment on a computer using chance. Being secret, their work required a code name. Von Neumann chose the name « Monte Carlo ». The name is a reference to the Monte Carlo Casino in Monaco where Ulam’s uncle would borrow money to gamble. Random methods of computation and experimentation (generally considered forms of stochastic simulation) can be arguably traced back to the earliest pioneers of probability theory (see, e.g., Buffon’s needle, and the work on small samples by William Sealy Gosset), but are more specifically traced to the pre-electronic computing era. The general difference usually described about a Monte Carlo form of simulation is that it systematically « inverts » the typical mode of simulation, treating deterministic problems by first finding a probabilistic analog (see Simulated annealing). Previous methods of simulation and statistical sampling generally did the opposite: using simulation to test a previously understood deterministic problem. Though examples of an « inverted » approach do exist historically, they were not considered a general method until the popularity of the Monte Carlo method spread. Monte Carlo methods were central to the simulations required for the Manhattan Project, though were severely limited by the computational tools at the time. Therefore, it was only after electronic computers were first built (from 1945 on) that Monte Carlo methods began to be studied in depth. ©Wikipedia_Monte_Carlo

Dilemme : si la masse critique est sous-évaluée, fiasco, des millions de dollars perdus et des secrets donnés à l’ennemi. Si elle est surévaluée, explosion prématurée à Los Alamos, ou Hanford ou Oak Ridge Essais de mesure de la masse critique un peu à l’écart du site principal, dans la Tech Area 2 où avait déjà été installé LoPo.

Le 18 janvier 1945 Otto Frisch évalua la masse critique d’U235 en augmentant progressivement la quantité et en surveillant l’activité neutronique. Facteur de multiplication sous-critique M = 1/(1—k) Le flux de neutrons est proportionnel à M, il «suffit» de porter la valeur de 1/M en fonction du nombre de blocs d’uranium (par exemple) et d’extrapoler la droite pour anticiper à quel moment la criticité sera atteinte. Il n’est pas nécessaire de déclencher une réaction en chaîne divergente !

12 avril 1945 Frisch fait la même mesure pour le plutonium [VERIFIER d’autres sources disent U235 final 31 mai, début des tests de criticité avec le plutonium]

Le 24 juin, Frisch confirme que la conception du cœur avec l’initiateur est correcte après les tests de criticité

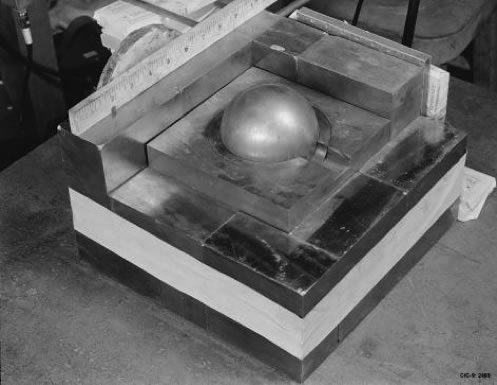

Ces expériences étaient extrêmement risquées, Feynman les comparait à chatouiller la queue d’un dragon. Le 4 juin 1945, une masse d’uranium franchit le seuil de criticité quand une fuite d’eau mouilla l’uranium, et la brève réaction en chaîne irradia gravement 3 personnes. Feynman avait auparavant signalé le risque de conserver des quantités importantes d’uranium dans l’eau, car son rôle de modérateur augmentait la probabilité de fission. Plus grave, le 21 août 1945, Harry K. Daghlian fit accidentellement tomber une brique de carbure de tungstène sur une sphère de plutonium de 6 kg, la brique servit de réflecteur de neutrons et la masse de plutonium devint supercritique. Daghlian reçut une dose de neutrons et de gammas de plus de 5 sieverts, et il mourut 3 semaines plus tard. Le 21 mai 1946, un accident analogue irradia Louis A. Slotin qui reçut une dose de 21 sieverts et mourut 9 jours plus tard.

Vérifier : une sphère de 6 kg de Pu a un diamètre de 8 cm, ce qui ne semble pas être le cas sur la photo.

Ces accidents de criticité n’ont pas entraîné une explosion nucléaire (il n’y a eu « que » 10^16 à 10^17 fissions dans ces accidents contre 10^24 pour Hiroshima) pour plusieurs raisons :

- l’assemblage se faisait beaucoup plus lentement que dans une bombe, 1 seconde au lieu d’un millionième de seconde (c’est d’ailleurs le titre du rapport LA-596 de Fuchs sur la question en 1946, Efficiency for very slow assembly) ;

- le dégagement d’énergie a conduit à une dilatation du cœur, à la libération de gaz (par radiolyse) et à une diminution de la section efficace par effet Doppler, conduisant à repasser en régime sous- critique ;

- les configurations correspondaient à un régime supercritique mais pas prompt-critique (i.e. la criticité n’est dépassée qu’avec les neutrons retardés, d’où une échelle de temps de l’ordre de la seconde et non de la microseconde).

| Contact: |  |

|---|